Infrastructure IA pour entreprises : guide complet avec HPE, NVIDIA et AI Cloud

Selon IDC, les investissements mondiaux en infrastructure pour l'intelligence artificielle dépasseront $200 milliards d'ici 2027, avec un taux de croissance annuel moyen de 42,2 %. L’essor des modèles de grande taille (LLMs), comme GPT-4 ou Gemini, impose aux entreprises des exigences techniques sans précédent. Par exemple, entraîner un LLM de dernière génération peut nécessiter plus de 10 000 GPU et consommer plusieurs centaines de mégawatts d’énergie.

Dans ce contexte, l'approche "cloud first" montre ses limites : volatilité des coûts, latence variable, contraintes de souveraineté. De plus en plus d’acteurs se tournent vers des solutions hybrides ou privées combinant des GPU NVIDIA H100 et des architectures cloud spécialisées.

Cet article analyse en profondeur l'approche HPE Private Cloud AI, les solutions NVIDIA pour l’infrastructure IA, et leur intégration dans un environnement AI Cloud performant, maîtrisé et évolutif.

HPE, NVIDIA, AI Cloud : trois composants d’un socle IA d’entreprise

🔸 HPE : du matériel à l’environnement IA privé

La solution HPE Private Cloud AI est conçue comme un cloud privé optimisé pour l’IA. Elle combine :

- Les serveurs HPE ProLiant et HPE Cray XD, validés pour l’accélération IA

- Une infrastructure software-defined pour orchestrer les ressources GPU/CPU

- Des frameworks préintégrés pour la gestion des workloads IA (Kubernetes, Red Hat, MLOps)

Elle permet une mise en œuvre rapide, une gouvernance locale des données, et une économie prévisible.

🔸 NVIDIA : la référence en accélération IA

NVIDIA reste le leader incontesté des architectures IA :

- GPU H100 : jusqu’à 30x plus performants que les A100 sur certaines tâches IA

- Plateformes DGX : serveurs spécialisés pour l'entraînement LLM

- Frameworks IA (cuDNN, TensorRT, Triton) nativement intégrés dans les offres cloud et on-prem

🔸 AI Cloud : scalabilité et accessibilité

Les hyperscalers (AWS, GCP, Azure) proposent des instances IA puissantes, mais :

- Les coûts OPEX explosent avec des charges intensives

- La souveraineté des données devient critique (notamment en santé, finance)

- Les modèles propriétaires sont souvent incompatibles avec les environnements IA internes

Une approche hybride combinant cloud public, cloud privé et edge devient donc nécessaire.

Pourquoi les charges IA rendent l’infrastructure traditionnelle obsolète

Des workloads intensifs, irréguliers et non linéaires

- Entraînement : nécessite des clusters à haute densité GPU, réseau InfiniBand, stockage parallèle

- Inference : dépend fortement de la latence, avec une réponse en millisecondes attendue

Des ressources massives à fournir rapidement

- Un modèle GPT-3 (175 milliards de paramètres) requiert ~350 Go de mémoire GPU pour une seule instance.

- La bande passante nécessaire atteint 3 à 5 To/s sur des clusters H100 avec NVLink + NVSwitch.

Des contraintes d’énergie et de refroidissement

- La densité thermique d’un rack IA peut dépasser 50 kW, imposant une conception data center spécifique.

- Des solutions de refroidissement liquide (liquid cooling) deviennent souvent nécessaires.

HPE Private Cloud AI + NVIDIA H100 : une approche industrialisée pour l’IA

Fruit d’un partenariat stratégique entre HPE et NVIDIA, la solution HPE Private Cloud AI intègre l’ensemble des composants nécessaires à un environnement IA d’entreprise : infrastructure matérielle optimisée, orchestration logicielle, sécurité, et support professionnel.

Du côté NVIDIA, cette intégration est également désignée sous le nom "NVIDIA AI Computing by HPE", reflétant la présence complète de la stack logicielle NVIDIA (frameworks, SDKs, pilotes, gestion GPU) déployée sur l’infrastructure HPE.

Une architecture modulaire et prête à l’emploi

| Composant | Fonction principale | ✅ Valeur ajoutée |

|---|---|---|

| HPE Private Cloud AI | Environnement IA complet en cloud privé | Déploiement rapide, orchestration native |

| GPU NVIDIA H100 | Accélération de l'entraînement et de l’inférence | Jusqu’à 30x plus rapide que les générations précédentes |

| HPE Cray ou ProLiant | Compute optimisé pour IA | Haute densité, gestion thermique avancée |

| Software-defined stack | Virtualisation et gestion Kubernetes/MLOps | Productivité DevOps/IA, gestion fine des coûts |

Sécurité et conformité

- Isolation complète des workloads sensibles (données santé, RH, R&D)

- Conformité RGPD et certification ISO/IEC 27001 (via HPE)

- Authentification multi-niveau, chiffrement natif, audit des accès

Comparatif : cloud public vs cloud privé IA

| ✔️ Critère | Cloud Public IA | HPE Private Cloud AI |

|---|---|---|

| Coût long terme | OPEX élevé, difficile à anticiper | CAPEX maîtrisé, TCO plus stable |

| Personnalisation hardware | Limitée (types d’instances) | Architecture sur mesure (GPU, stockage, réseau) |

| Délais de provisioning | Variables selon disponibilité | Environnement dédié, provisioning instantané |

| Conformité / RGPD | Soumis à la législation des pays d’hébergement | Données hébergées localement |

| Évolution / scalabilité | Excellente mais mutualisée | Scalable selon les besoins métiers |

La tendance 2025 est clairement au modèle hybride, où l'entraînement de modèles lourds peut être réalisé en cloud privé, et l’inférence ou la mise en production dans un AI Cloud à la demande.

Étude de cas : implémentation d’une infrastructure IA avec HPE Private Cloud AI et NVIDIA

Contexte

Un acteur bancaire européen souhaite entraîner un modèle NLP propriétaire (analyse de documents contractuels, langage juridique) en interne, sans externaliser ses données sensibles vers un cloud public.

Solution mise en œuvre

Le déploiement repose sur la solution HPE Private Cloud AI, configurée avec les composants suivants :

- Infrastructure matérielle : 4 nœuds HPE Cray XD, intégrés dans un cluster validé pour IA

- Accélération GPU : 256 NVIDIA H100, interconnectés via InfiniBand HDR

- Orchestration logicielle : stack software-defined intégrée (Kubernetes, Red Hat OpenShift)

- Services managés : déploiement réalisé par HPE Pointnext, support complet sur l’ensemble du cycle de vie

L’environnement respecte les prérequis de la solution Private Cloud AI, avec :

- Provisioning automatisé via des modèles validés IA

- Sécurité native (chiffrement, segmentation des workloads)

- Gouvernance centralisée des ressources IA

Résultats observés

- Réduction du temps d'entraînement : de 45 jours à 8 jours pour un LLM maison

- Économie budgétaire : -34 % par rapport à une configuration cloud public équivalente sur 12 mois

- ROI atteint en 9 mois grâce à la réduction des temps de traitement et à la mutualisation des ressources IA

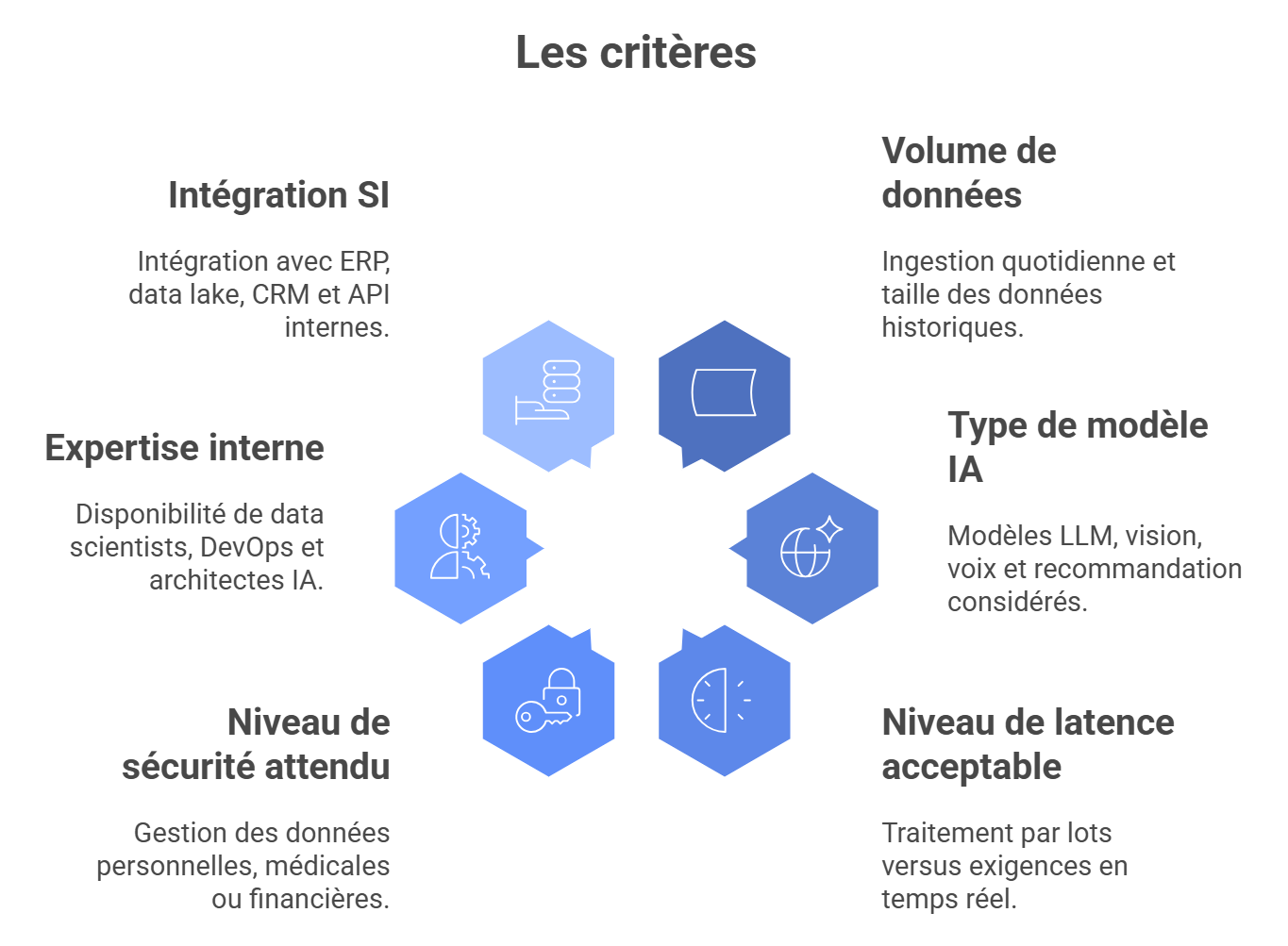

Sélectionner son infrastructure IA : critères 2025

Avant d’investir, les DSI et responsables IA doivent poser les bonnes questions :

Une analyse TCO et un POC sur charge réelle sont indispensables pour calibrer correctement les ressources.

Conclusion

L’évolution rapide de l’IA rend caduques les approches classiques d’infrastructure IT. Pour les entreprises, combiner GPU NVIDIA H100, cloud privé optimisé et modèle hybride est aujourd’hui la stratégie la plus robuste et durable.

La solution HPE Private Cloud AI permet aux organisations de déployer un environnement prêt à l’usage, sécurisé, performant et maîtrisé, tout en restant ouvert aux extensions cloud.